- Home

- FEATURES

- Crawl Budget

- Status Codes

- Business-relevante Seiten

- Crawl Frequenz

- Crawl Budget Verschwendung

- Top-50 URLs

- Top-50 Ressourcen

- Top-10 Verzeichnisse

- Selbst definierte Gruppen

- Top-10 Produkte

- Gecrawlte Parameter

- HTTP vs. HTTPs Crawls

- Unterschiedliche Googlebots

- Content Typen

- Crawl-Budget Optimierung

- Google’s Indexierungsprozess

- Preise

- FAQ

- Über uns

- News & Co.

- EN

- Demo-Zugang

- Free Info Call

SaaS Logfile Analyse Tool für SEOs

☛ Jetzt überzeugen!

(1/2) @g33konaut @methode @JohnMu The past few weeks I've been my own crawler & indexer, collecting data from all sorts of specific resources over the internet & podcasts to put together a big picture of the Google indexing process. It's of course incomplete & greatly simplified! pic.twitter.com/5NmJI26pNW

— Jan-Peter Ruhso (@JanRuhso) October 29, 2021

crawlOPTIMIZER analysiert Logfiles vollautomatisiert

Wirf einen Blick unter die Motorhaube Deiner Webseite!

In unserem übersichtlichen crawlOPTIMIZER Dashboard hat man die Aktivitäten des Googlebots rund um die Uhr im Blick. Dank der Logdatenspeicherung und dem von uns entwickelten Logfile-Explorer sind selbst rückwirkende Analysen jederzeit und problemlos möglich.

Fix & fertige Auswertungen

Vordefinierte Analysen & Auswertungen helfen selbst SEO-fremden Personen Crawling-Probleme mühelos aufzudecken.

Serverstandort Deutschland & DSGVO konform

Keine User-bezogenen Daten werden analysiert & gespeichert. DSGVO konform.

Collecting data is no deal. Understanding data is our deal!

Bastian Grimm, Peak Ace AG

Erfreulicherweise integriert sich das Tool zudem nahtlos in vorhandene Workflows und ist zudem super flexibel. Das macht die Anbindung verschiedenster Datenquellen zur Anlieferung und Auswertung von Logfiles zum Kinderspiel.“

Bastian Grimm, CEO & Director Organic Search bei Peak Ace AG

Welche Inhalte werden von Google gecrawlt?

alle Insights ausgezogen, wie Google Deine Webseite erfasst/crawlt. Er zeigt Dir auf einen Blick, welche Inhalte vom Googlebot ausgelesen werden und ob wichtige Inhalte unter Umständen gar nicht gecrawlt werden.

Um Langzeitanalysen zu ermöglichen, können auf Wunsch Deine Logfiles bis zu 5 Jahre lang gespeichert werden. Alle Maßnahmen verfolgen das Ziel, den unbezahlten Suchmaschinen-Traffic zu steigern.

- Logfile Analysen auf Knopfdruck & ohne Aufwand

- Alle Googlebot-Aktivitäten rund um die Uhr im Blick

- Dashboard mit fixfertigen & verständlichen Auswertungen

- Kein spezifisches SEO-Logfile-Know-how nötig

- Manuelle Analysen & Reports dank Logfile Explorer

- Langzeitanalysen bis 5 Jahre dank cloudbasierter Lösung

- Ultra einfache & schnelle Übermittlung der Logfiles

- Einmaliges, einfaches Andocken – Deine IT wird uns lieben!

- 100% DSGVO konform

Wer sollte den crawlOPTIMIZER nutzen?

1. Kernzielgruppe

crawlOPTIMIZER richtet sich an alle Personen, die den unbezahlten Suchmaschinen-Traffic in Unternehmen verantworten und wenig Zeit für ausführliche, regelmäßige Logfile-Analysen haben oder über kein spezifisches Know-how verfügen. Beispiele:• Head of SEO

• SEO-Manager

• Head of Online Marketing

• Online Marketing Manager

• Head of e-Commerce

• e-Commerce Manager

• Webmaster / IT-Admins

• SEO-Agenturen

2. Webseiten

crawlOPTIMIZER wurde speziell für Webseiten ab einer Größe von einigen tausend Pages entwickelt oder Online-Unternehmungen, die großes Interesse an einer Steigerung des unbezahlten Suchmaschinen-Traffics haben. Beispiele:

• Online-Shops

• News-Portale

• Wetterseiten

• Informationswebseiten

• e-Commerce Webseiten

• Große Blogs / Foren etc.

Stephan Czysch, Dept Agency

Der crawlOPTIMIZER bereitet die Logfiles Deines Servers ideal auf und lässt Dich Potenziale sehr schnell identifizieren. Durch eine Anpassung der robots.txt im Nachgang an Logfile-Analysen konnten wir speziell für große Online Shops deutliche Traffic-Gewinne erzielen.“

Stephan Czysch, Autor mehrerer SEO-Fachbücher & Dozent für SEO

Wozu brauche ich den crawlOPTIMIZER?

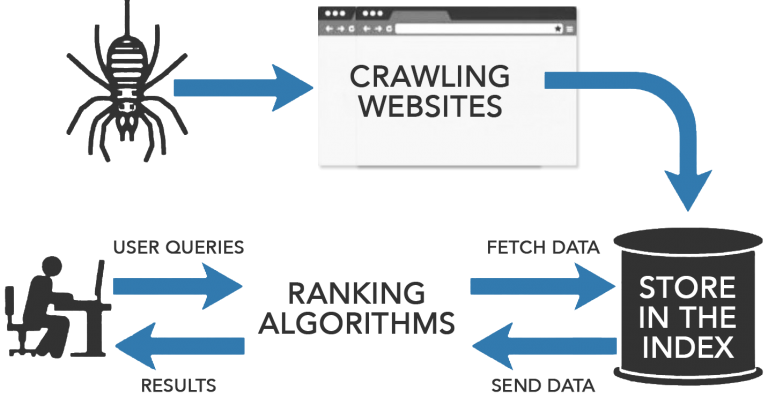

Ohne Crawling gibt es keine Indexierung und somit auch keine Platzierung in den Google-Suchergebnissen.

Deine Webseite kann nur über die Google-Suche gefunden werden, wenn sie vorab in den Google-Index aufgenommen wurde. Für diesen Zweck crawlt (=durchsucht) der Googlebot (auch Spider genannt) täglich alle verfügbaren Webseiten weltweit, auf der Suche nach neuen und aktualisierten Inhalten.

Mit Hilfe diverser Onsite-Optimierungsmaßnahmen kannst Du einen gewissen Einfluss auf den Crawling-Prozess nehmen und somit bestimmen, welche Inhalte in den Google-Index aufgenommen und welche Inhalte häufiger gecrawlt werden sollen.

Nur die Webserver-Logfiles geben Aufschluss darüber, welche und wie häufig der Googlebot Inhalte crawlt. Daher sollte ein kontinuierliches Crawling-Monitoring in allen größeren Online-Unternehmungen als Prozess verankert werden. Für diesen Zweck wurde der crawlOPTIMIZER entwickelt, getreu dem Motto: Keep it as simple as possible.

„Der Google-Bot ist der Webcrawler (auch „Spider“ genannt) von Google. Crawling wird der Prozess genannt, durch den der Google-Bot neue und aktualisierte Seiten ermittelt, damit sie dem Google-Index hinzugefügt werden können.“ Quelle: Google Search Console

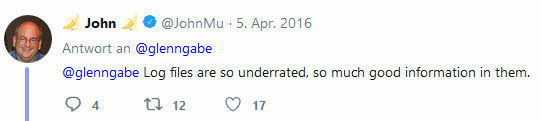

John Müller

Webmaster Trends Analyst bei Google

„Log files are so underrated, so much good information in them.“ (Twitter)

Prof. Dr. Dominik Große Holtforth

Experte für E-Commerce

„[…] Wie man sieht, sind Crawlability und das Crawl Budget mehr als ein SEO Mythos, sondern eine handfeste Optimierungsaufgabe. Da sie eher abstrakt ist, gerät sie unter Umständen eher ins Hintertreffen als konkrete Onsite-Optimierungsmaßnahmen. Diese laufen allerdings ins Leere, wenn man die Qualität der Website aus der Crawlingperspektive nicht im Auge behält.“ Zur Originalquelle

Welchen Zweck erfüllt der crawlOPTIMIZER?

1. Nutzen & Mehrwert

crawlOPTIMIZER liefert wertvolle Insights, wie Google Deine Webseite erfasst, d.h. welche Inhalte von Google „ausgelesen“ werden können und welche nicht. Relevant sind diese Informationen, da es ohne Crawling kein Ranking und folglich keinen Suchmaschinen-Traffic gibt. Beispiele:

- Wo ver(sch)wendet Google Ressourcen?

- Werden meine wichtigen Inhalte gecrawlt?

- Welche Inhalte werden gar nicht gecrawlt?

- Hat der Googlebot Probleme beim Crawling?

- Logfiles helfen die interne Verlinkung zu optimieren

- Mittels Logfiles identifiziert man präzise Orphan Pages

- Bei professionellen Website-Relaunches

- Logfiles sind das perfekte Backup bei ungewollten URL-Änderungen

- Und viele weitere Optimierungspotenziale…

2. Ziele

- Neue & geänderte Inhalte sollen möglichst schnell im Google-Index aufgenommen werden (z.B. neue Produkte indexieren / Title-Tag & Meta-Description Änderungen / neue Robots-Anweisungen / neue oder geänderte Textinhalte uvm)

- Nur SEO-Landingpages sollen gecrawlt werden – keine Verschwendung von Google-Crawls

- Shift / Verschiebung von ursprünglich verschwendeten Google-Crawls auf SEO-Landingpages

- Ein nahezu vollständiger Crawl der gesamten Webseite (SEO-relevante Seiten) in möglichst kurzer Zeit

- Fehler der eigenen Webseite bzw. Infrastruktur rasch aufdecken und umgehend beseitigen (z.B. 4xx, 5xx Fehler)

- Schonender & effizienter Umgang mit Ressourcen (Serverinfrastruktur, Traffic etc.), sowohl intern, als auch bei Google

- Stärkung der Marke

Folglich: Steigerung der Sichtbarkeit & des kostenlosen Traffics

3. Crawling kostet Geld

Google crawlt von Haus aus nicht effizient. Das liegt in der Natur der Bots. Doch Deine Server-Ressourcen werden durch ein ineffizientes Crawling unnötig stark belastet. Und das kostet auch Dich bares Geld. Helfen wir dem Bot seine Effizienz zu steigern, zugunsten Deines SEO-Erfolges.

„Wenn Sie Google-Produkte verwenden, erledigen die Server in unseren Rechenzentren die Arbeit für Sie – weltweit und rund um die Uhr. Unsere Server unterstützen viele Produkte gleichzeitig. Dies ist die so genannte „Cloud“. Indem wir unsere Server ständig beschäftigen, können wir mit weniger Aufwand mehr erledigen […]“, Quelle: Google

- Google betreibt weltweit 15 Rechenzentren

- Betriebskosten pro Jahr 10+ Mrd. USD

- Das Crawling von Webseiten kostet Google das meiste Geld

Daniel Dietrich, XXXLUTZ

Professionelle, permanente Logfile Analysen zu fahren, bedeuten großen Zeitaufwand, alleine schon für die Aufbereitung der Daten. Der crawlOPTIMIZER nimmt uns diese Arbeit ab und wir können uns endlich auf das Wesentliche konzentrieren.“

Daniel Dietrich, Head of SEO der XXXLUTZ-Gruppe

Highlights

Googlebot Aktivitäten

Sehen und verstehen welche Seiten von Google gecrawlt werden. Ziel: Maßnahmen ableiten, die das Crawling verbessern können.

Fertige Analysen & Auswertungen

Das Herzstück des Tools ist das Dashboard mit den fixfertigen & relevanten Auswertungen. Durch dieses Dashboard ersparst Du Dir extrem viel Deiner kostbaren Zeit.

Datenspeicherung bis zu 5 Jahre

Endlich sind rückwirkende Logfile Analysen ohne Aufwand möglich! Dank der Logdatenspeicherung in einer sicheren Cloud. Jederzeit und überall abrufbar.

Einfach & verständlich

Alle vordefinierten Analysen & Auswertungen sind so aufgebaut, dass sie möglichst alle verstehen – selbst ohne spezifischem SEO-Background!

Schnelle & einfache Anbindung

Um möglichst einfach Deine Logdaten ziehen zu können, haben wir mehrere Alternativen erarbeitet. Das einmalige Setup wird so zum Kinderspiel.

24/7 Support

Bei Fragen stehen wir Dir jederzeit zur Seite. Sehr gerne unterstützen wir Dich beim erstmaligen Setup. Zudem kommunizieren wir gerne auch direkt mit Deiner IT oder mit Deinem Hostingprovider.

Feature-Highlight: Business-Relevant Pages

Die beiden Herzstücke des Tools

1. Übersichtliches Dashboard

Alle KPIs & Auswertungen wurden so aufbereitet, dass sie selbst für Personen ohne SEO-Background verständlich sind.

Top Analysen im Dashboard

- Crawl-Budget Statistik & Verschwendung des Crawl-Budgets

- Status Codes & Crawling-Statistiken

- Crawling von Business-relevanten Seiten

- Top-50 gecrawlte URLs & Ressourcen

- Top-10 gecrawlte Verzeichnisse & Produkte

- Gecrawlte Content-Typen, Parameter & http(s)

- Crawling-Frequenzen einzelner Pages

- Noch nicht gecrawlte Pages

- XML-Sitemap Check

- Darstellung unterschiedlicher Googlebots

2. Der Logfile-Explorer

Verarbeitung nahezu unbegrenzt großer Datenmengen

Da Deine Logdaten auf unseren Hochleistungs-Servern automatisch verarbeitet & archiviert werden, kannst Du jederzeit und von überall aus darauf zugreifen. So kannst Du Langzeitanalysen & rückwirkende Analysen mühelos bewerkstelligen.

Einfache, unendliche Filtermöglichkeiten + Exportfunktion

Unser Logfile-Explorer bietet Dir einfache Filtermöglichkeiten, um so individuelle Analysen und Auswertungen zu erstellen. Mit nur wenigen Klicks kannst Du Deine benötigten Daten & Informationen ziehen. Zudem kannst Du Deine Abfragen als Quick-Filter abspeichern. Deine (gefilterten) Logdaten kannst Du jederzeit als XLSX- oder CSV-File exportieren.

New & Hot: Google INDEXING API

Dank der Google Indexing API kannst jetzt nicht nur Deine Logs analysieren, sondern auch gleich Re-Crawls anstoßen oder URLs aus dem Google Index entfernen lassen. Alles aus einer Hand!

Datamining dank GSC API

Google Search Console API

Du kannst Dein(e) Projekt(e) mit nur einem Klick mit der Google Search Console verbinden. Dadurch werden Deine Logdaten mit Search-Daten angereichert (Clicks, Impressions, CTR, etc.). Yeah!

FAQ

Häufig gestellte Fragen

ERSTE SCHRITTE

Ist der crawlOPTIMIZER DSGVO konform?

Ja, selbstverständlich!

Wir halten uns an die Datenschutzrichtlinien. Es werden KEINE personenbezogenen Daten gespeichert oder analysiert, sondern lediglich die Daten des Googlebots.

Der Serverstandort befindet sich in Deutschland.

Wie lange gelten die Einführungspreise?

Einmal abgeschlossene Einführungspreise sind zeitlich unbegrenzt und gelten daher über die gesamte Vertragsdauer.

Welchen Tarif soll ich wählen?

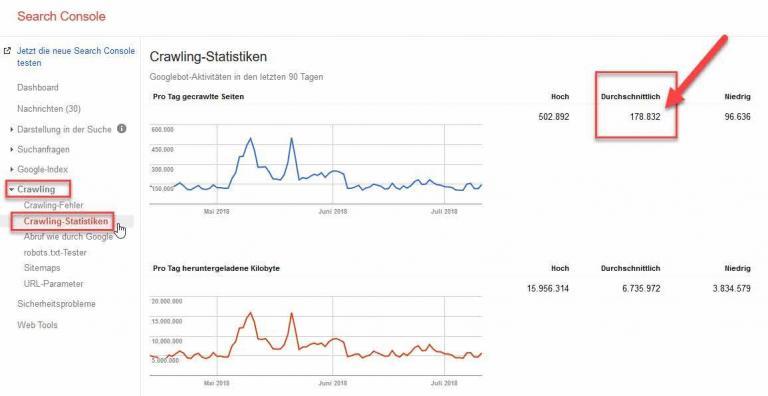

Beispiel: Wenn Deine Webseite zwischen 25.000 und 75.000 Google-Bot Requests pro Tag hat, solltest Du den Tarif MATT wählen.

Unsere Tarife unterscheiden sich bei den maximalen Google-Requests pro Tag und der Dauer der Logdatenspeicherung. Während die MATT-Version eine maximale Anzahl an Google-Bot Requests pro Tag von 75.000 zulässt, hat man im Tarif LARRY eine maximale Anzahl von 500.000 Google-Requests pro Tag inklusive. Solltest Du mehr als 500.000 Requests pro Tag benötigen, nimm bitte persönlich mit uns Kontakt auf, damit wir Dir ein maßgeschneidertes Angebot legen können.

Fazit: Schaue in der Google Search Console nach, wie viele Requests Deine Webseite pro Tag im Durchschnitt der letzten 90 Tage hatte und wähle anhand dieser Zahl den passenden Tarif.

Solltest Du keinen Zugriff auf die Daten der Google Search Console haben, ist das auch kein Problem. Entscheide Dich für einen Tarif und informiere uns per E-Mail darüber. Wir tracken daraufhin einen Monat lang Deine Log-Daten auf die Gesamtsumme pro Tag und informieren Dich dann über den passenden Tarif.

Was passiert nach meiner Bestellung?

Sobald Deine Bestellung bei uns eingegangen ist, werden wir für Dich Deine eigene Infrastruktur auf einem unserer Server einrichten.

Sobald dieser erste Schritt getan ist (dauert max. einen Werktag) werden wir Dich per E-Mail informieren. In unserer E-Mail werden wir Dir dann Deine Möglichkeiten aufzeigen, wie Du uns Deine Logfiles übermitteln kannst. Bitte entscheide Dich für eine Variante und gib uns so rasch wie möglich dazu Feedback.

Sobald wir alle nötigen Informationen haben, setzen wir Deinen Account vollständig auf (dieser Prozess ist nur einmalig nötig).

Fazit: Spätestens eine Woche nach Deiner Bestellung solltest Du bereits mit Deinen Logfile-Analysen starten können.

Sind die Analysen & Auswertung im Tool tagaktuell?

Ja, vom Vortag.

Die Logdaten werden immer auf Tagesbasis gezogen. In der Nacht ab ca. 00.00 Uhr werden die Logdaten vom Vortag gezogen, gespeichert und anschließend beginnt der crawlOPTIMIZER mit allen notwendigen Aggregationen, damit Dir in der Früh alle Analysen & Auswertungen fertig zur Verfügung stehen. So kannst du bis zu 60 Monate analysieren und auswerten.

Gibt es ein LIVE-Monitoring des Googlebots?

Nein, das haben wir nicht eingeplant.

Aufgrund der enormen Komplexität der fertigen Analysen und Auswertungen die etliche Stunden Server-Ressourcen in Kauf nehmen, ist ein LIVE-Monitoring leider nicht machbar. Dafür bekommst Du fixfertige Analysen & Auswertungen, die Dir Deinen Berufsalltag signifikant erleichtern.

Alle Analysen & Auswertungen sind daher vom Vortag und älter (bis zu 60 Monate).

Was ist wenn ich die maximalen Requests pro Tag überschreite?

Das ist in jedem Fall kein Beinbruch.

Solltest Du allerdings über einen konstanten Zeitraum von 90 Tagen die durchschnittliche Höchstgrenze an Requests Deines gewählten Tarifs überschreiten, werden wir Dich darüber informieren und Deinen Tarif in Abstimmung mit Dir fair anpassen.

GOOGLE SEARCH CONSOLE

Wo finde ich in der GSC die Anzahl der Googlebot-Zugriffe?

- Melde Dich in Deiner Google Search Console an

- Klicke auf „Crawling“

- Danach auch „Crawling-Statistiken“

- Dort findest Du die „Average Crawls“

ERSTMALIGES SETUP

Wie weiß ich, ob meine Logfiles geeignet sind?

Grundsätzlich können wir mit Logfiles von allen unterschiedlichen Servern (Apache, nginx, etc.) arbeiten, da wir alle Logfiles einmalig und individuell einrichten. Logfiles im JSON-Format können auch problemlos verarbeitet werden.

Du kannst uns aber trotzdem gerne per E-Mail einen Auszug Deiner Logfiles übersenden. Wir prüfen sie und geben Dir asap Feedback.

Wie kann ich meine Logfiles an den crawlOPTIMIZER übermitteln?

Wir bieten Dir vier einfache Möglichkeiten an, uns Deine Logfiles automatisiert und dauerhaft zu übermitteln. Das Setup muss nur einmalig eingerichtet werden und ist in der Praxis nicht aufwändig.

1. (S)FTP-Download

Wir bekommen einen eigenen, sicheren Zugriff auf Deinen (S)FTP-Server (gerne auch via IP-Access abgesichert), wo Deine Logfiles täglich abgelegt werden. Wir downloaden die Logfiles täglich vollautomatisiert und selbsttätig.

2. SFTP-Upload

Wir stellen Dir einen eigenen SFTP-Server zur Verfügung. Du bekommt von uns alle Zugangsdaten & Zugriffsrecht. Und Du legst Deine Logfiles täglich, automatisiert auf unserem SFTP-Server ab.

3. CURL-Download

Wir bekommen via URL die Möglichkeit, Deine Logfiles täglich zu ziehen.

4. Täglich per E-Mail (für kleine bis mittlere Webseiten geeignet)

Du kannst uns Deine komprimierten Logfiles täglich per E-Mail übersenden. Hierfür bekommst Du von uns eine eigene E-Mail Adresse, an die Du Deine Logs sendest. Bitte beachte jedoch, dass jede E-Mail nicht größer als 10MB sein sollte. Du kannst uns aber natürlich mehrere E-Mails à 10MB pro Tag senden.

Solltest Du eine weitere hier nicht aufgelistete Variante mehr bevorzugen, lass es uns einfach wissen und wir richten alles nach Deinen Vorgaben ein.

Muss die IT die Logfiles irgendwie aufbereiten bzw. vorfiltern?

Ja, bitte.

Da wir keine userbezogenen Daten erhalten und verarbeiten wollen, muss die IT folgende Vorfilterung der Logfiles durchführen:

Vorfilterung der Access-Logs nach dem Begriff „google“ innerhalb des „User Agents„. D.h. der Begriff „google“ muss innerhalb des User Agent-Strings vorkommen (egal in welcher Schreibweise. Positive Beispiele: Googlebot, google, Google, GOOGLE). Alle übrigen Logeinträge ohne „google“ wollen wir im Idealfall nicht bekommen und sollen daher nicht abgelegt / übermittelt werden.

Zwei Beispiele:

- Mozilla/5.0 (Linux; Android 6.0.1; Nexus 5X Build/MMB29P) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/41.0.2272.96 Mobile Safari/537.36 (compatible; Googlebot/2.1; +http://www.google.com/bot.html)

- Googlebot-Image/1.0

Sollten wider Erwarten versehentlich doch andere Logeinträge übermittelt worden sein, werden diese beim Import der Logfiles durch eine automatische Prüfung identifiziert und unwiderruflich gelöscht.

Wie ermittelt ihr den echten Googlebot?

Mittels Reverse-DNS wird jede uns noch nicht bekannte IP geprüft, ob sie auch tatsächlich von Google stammt.

Unsere Engine arbeitet selbstlernend und erweitert so automatisch die Anzahl der uns bekannten Google-IPs, um noch schneller ein Matching durchzuführen.

Crawlt ihr selbst auch meine Webseite?

Ja! Um den crawlOPTIMIZER allumfänglich nutzen zu können, ist ein Crawling Deiner Webseite(n) nötig. Das Crawling findet i.d.R. einmal pro Woche nachts statt und wird nach Deinen individuellen Vorgaben eingestellt.

Was crawlen wir?

Unser Crawler crawlt lediglich alle Einträge (URLs) aus Deinen XML-Sitemaps.

Folgende Crawling-Standardwerte sind in den Settings hinterlegt:

- Sitemap Import Weekday: Monday

- Sitemap Import Time: 01:00:00 Uhr (CET)

- Crawl Start Time: 02:00:00 Uhr (CET)

- Crawl End Time: 06:00:00 Uhr (CET)

- Crawl Rate: 5 URLs pro Sekunde

Diese Standardwerte können jederzeit durch den Kunden im Menüpunkt „Settings“ individuell angepasst werden.

Wenn kein Crawling der XML-Sitemap(s) gewünscht ist, muss die Crawl Rate in den „Settings“ auf den Wert „0“ gesetzt werden. Dies hätte dann zur Folge, dass kein Crawling durch den crawlOPTIMIZER stattfindet. Im Falle eines „Nicht-Crawlings“ der XML-Sitemaps kann die Auswertung „Do not waste your crawl budget (XML-Sitemap Check)“ im Dashboard nicht angezeigt werden, da die benötigten Crawling-Informationen fehlen.

Weitere Informationen:

- Die in den „Settings“ maximal einstellbare Crawl Rate ist mit 10 URLs pro Sekunde limitiert. Höhere Crawl Rates nur auf Anfrage.

- Der crawlOPTIMIZER User Agent ist wie folgt aufgebaut:

Mozilla/5.0 (compatible; crawlOPTIMIZER/0.0.1; +https://www.crawloptimizer.com)

Wie lautet euer User Agent?

Mozilla/5.0 (compatible; crawlOPTIMIZER/0.0.1; +https://www.crawloptimizer.com)

Kontakt

Hinterlasse uns einfach eine Nachricht auf Skype oder WhatsApp